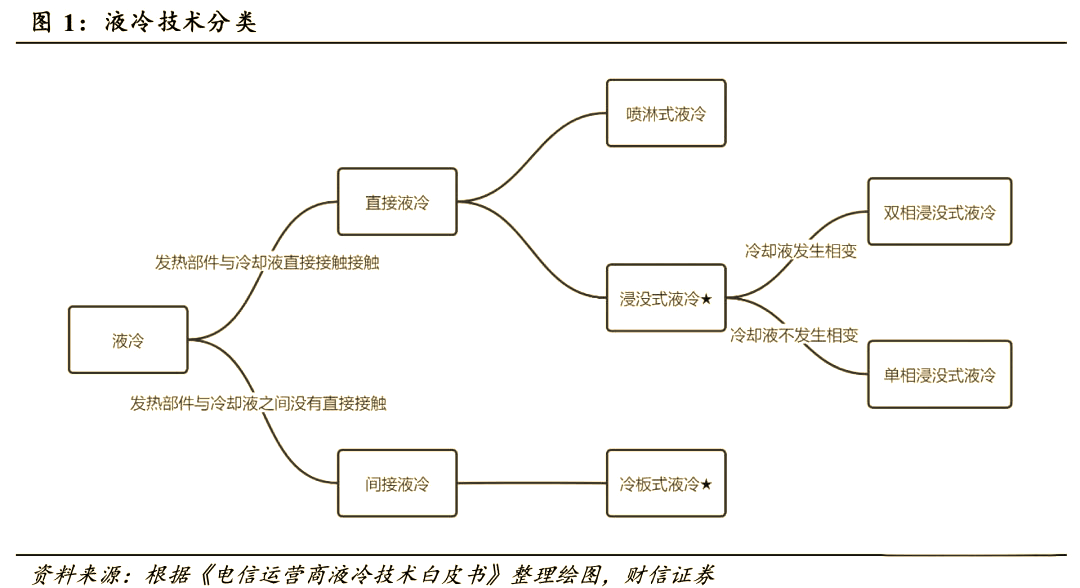

液冷,一种高效的散热技术,以液体为冷媒,借助其高热容和出色的热传导性,通过流动液体将IT设备内部元器件产生的热量导出至设备外部,从而确保IT设备在适宜的温度范围内稳定运行。这种技术根据冷却液与发热器件的接触方式,可分为间接液冷和直接液冷两大类。间接液冷,如冷板式液冷技术,特点在于服务器热源与冷却液不直接接触。而直接液冷,包括浸没式和喷淋式液冷技术,则是让发热部件与冷却液直接接触,实现高效冷却。此外,浸没式液冷还可进一步根据冷却液是否发生相变,分为单相浸没式液冷和双相浸没式液冷。目前,冷板式液冷和浸没式液冷是液冷技术领域的主要应用形式。

a、政策推动

【关于PUE】

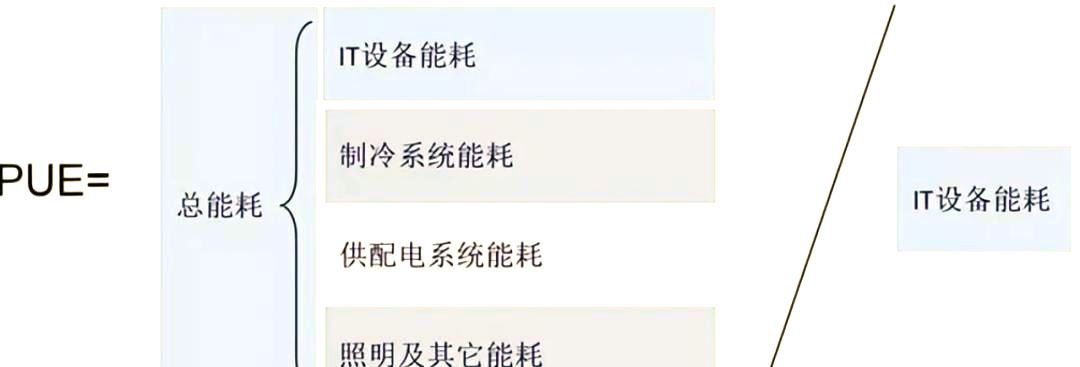

PUE,即数据中心总耗电与IT设备耗电的比值,是衡量数据中心能源利用效率的重要指标。比值越接近1,说明数据中心能源越能高效利用。当前,我国数据中心的平均PUE为1.49,仍有半数以上区域的数据中心PUE高于1.5。面对这一现状,国家和地方纷纷出台政策,对新建和老旧数据中心的PUE进行严格管控,明确要求东西部枢纽节点数据中心PUE分别控制在1.25和1.2以下。这也进一步推动了液冷技术的快速发展与应用。

液冷产业链的技术门槛相对较低,其上游主要涉及一些零部件的供应,而下游则是面对有数据中心需求的各种客户。中游的液冷厂所涉及的核心部件包括冷却塔、干冷器、冷板、管路以及导热材料,此外还有冷链分配器和控制算法等关键技术。

【高澜股份纪要—液冷厂商核心部件的采购情况】

一套完整的液冷系统通常包含CDU、tank、manifold以及一些重要的仪表。其中,CDU和TANK都拥有完全自主的知识产权,并由厂商自主设计和制造。整体的manifold分配水的管路也是厂商的自主设计。然而,在更底层的原材料方面,大部分部件需要外购。从价值量来看,CDU的价值最高,其次是Tank(即机柜),它承载了所有的服务器。管路的价值则因其所涉及的系统量较大而难以简单类比。最终,我们以单位千瓦为计算单位,发现CDU的价值仍然是最高的,而Tank的数量则是最多的。至于外部管路,其布局如同蜘蛛网一般复杂。

在液冷行业的核心厂商方面,我们了解到有循环泵厂家如大元泵业、钣金柜制造商、热孵化技术提供商以及冷板制造商如三花智控等。这些信息表明,液冷系统虽然包含多个组件,但其技术并非高度复杂,涉及的零部件也相对成熟。因此,液冷行业可能更像是一个贝塔的投资机会。

a、市场规模

b、市场参与者

当前,曙光公司以其冷本和浸没技术领跑市场,华为紧随其后,主要采用冷板技术。阿里则更偏向于浸没技术,且其技术主要应用于自用。联想和浪潮也位列前五,同样侧重于冷板技术。值得注意的是,冷板技术的技术门槛相对较低,仅需数百万的投资即可组建团队实现。而英维克、高澜股份等公司则可能位列第三梯队。目前,服务器厂商的液冷项目多由自家液冷团队完成,但也不排除引入第三方液冷厂商以降低成本的可能性。

a、需求增长

随着人工智能技术的迅猛发展,AI服务器的需求呈现出持续攀升的态势。这类服务器通常采用CPU+GPU/FPGA/TPU等异构架构,配备大量高功率的CPU和GPU芯片。例如,用于训练ChatGPT的英伟达AI服务器(NVIDIA DGXA100 640GB)便内置了8张NVIDIA A100 80GB Tensor Core GPU(每张250w)和1颗AMD Rome 7742 CPU处理器(225w),其系统功耗可高达6.5KW。因此,未来液冷服务器的市场需求有望进一步扩大。

再来看价格因素,根据相关纪要显示,机柜的造价约为500万元,其功率为200kw。这意味着,每增加1kw的算力,就需要投入2.5万元的资金(以冷板价格计算)。随着算力需求的不断攀升,这种资金投入也将呈现出持续增长的态势。

2、液冷技术的发展动力

在“双碳”目标的指引下,国家政策对数据中心的能源效率提出了严格要求。新建大型和超大型数据中心必须达到平均PUE低于1.3,国家枢纽节点的PUE更要降至1.25以下。由于风冷技术难以达到这一标准,液冷技术成为了必然的选择。此外,国家对PUE指标的硬性规定也使得行业趋势明朗,液冷技术已成为数据中心节能降碳的标配。

b、效率挑战

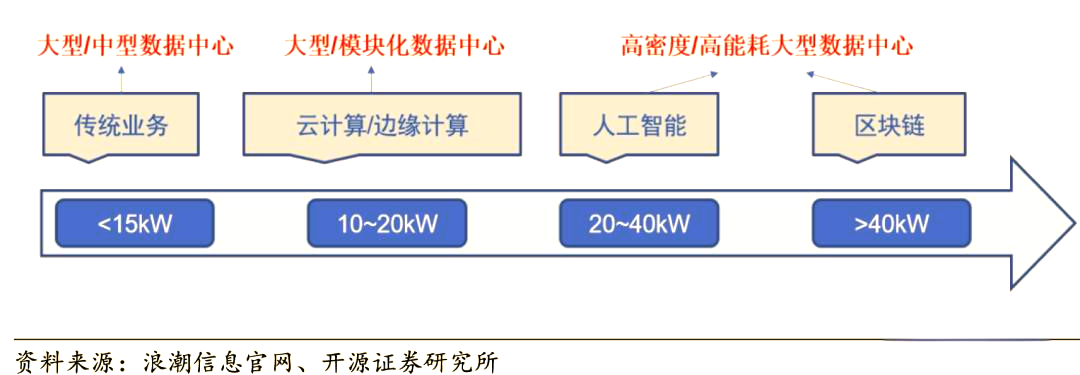

传统的风冷数据中心在面对12kw以内的机柜制冷时表现尚可,然而,一旦机柜功率超越15kw,风冷散热系统的效能便捉襟见肘。据Uptime Institute Intelligence的数据显示,2020年全球范围内,5-9kW/柜的机架占比最高,同时,功率超过10kW/柜的机架占比也接近30%。随着数据量的迅猛增长,数据中心需要更多的服务器来提供强大的计算能力。然而,受到数据中心建设面积和环保规定的双重制约,提升单机柜功率成为了平衡计算需求与有限承载能力的重要手段。赛迪顾问预测,未来几年内,随着数据中心算力的快速增长,高功率单机柜将逐渐普及,预计到2025年,全球数据中心的平均功率将达到25kW,这意味着AI服务器单机柜功率很可能超过12kw。

c、我国市场动态

据《2021-2022年度中国数据中心基础设施产品市场总报告》揭示,2021年,我国单机柜功率在10kW及以上的数据中心市场规模呈现出迅猛的增长势头,增长率高达10%以上。特别是在高密度数据中心领域,那些单机柜功率超过30kW的数据中心增长尤为迅速,增长率达到了31%。

3、液冷行业产业链

4、市场情况

2022年,中国液冷服务器市场规模已达到10.1亿美元,预计2023年将激增至15.1亿美元。当前,冷板技术在液冷市场中占据主导地位,市场占有率高达60%-70%。值得注意的是,采用第三方冷板技术可能面临责任不明确的问题。尽管新建服务器中液冷技术的占比可能达到50%,但旧服务器的改造进度尚不及此。

5、未来需求展望

8张A100芯片的总算力高达4.8P。

中国未来算力需求的展望:

在过去的几年里,中国的智能算力规模一直在迅速增长。2021年,这一规模达到了155.2EFlops,而到了2022年,这一数字已经攀升至268EFlops(根据IDC数据,按FP16计算,即268000P)。展望未来,中国AI算力规模的增长势头不减。预计到2026年,这一规模将激增至1271.4EFlops,实现年均52.3%的复合增长率,迎来快速增长的新阶段。

若以kw为单位进行计算,每增加1P算力,需消耗约0.74kw的电力。据此预测,到2026年,中国AI算力将年均增长160000P,同时电力消耗也将相应增长,达到118400kw。此外,随着算力规模的迅速扩大,相关投入也将大幅增加,预计年增长将超过30e人民币。

液冷,一种高效的散热技术,以液体为冷媒,借助其高热容和出色的热传导性,通过流动液体将IT设备内部元器件产生的热量导出至设备外部,从而确保IT设备在适宜的温度范围内稳定运行。这种技术根据冷却液与发热器件的接触方式,可分为间接液冷和直接液冷两大类。间接液冷,如冷板式液冷技术,特点在于服务器热源与冷却液不直接接触。而直接液冷,包括浸没式和喷淋式液冷技术,则是让发热部件与...

随着电力需求增长和空气冷却技术的不足,液冷技术逐渐成为数据中心的主导技术。尤其在高密度服务器的应用中,液冷技术成为解决日益增长的电力与冷却挑战的重要手段。冷却液分配单元(CDU)在这一背景下显得尤为重要,承担着热负荷管理的关键角色,特别是在人工智能和高性能计算领域,其作用愈发凸显。 02海外CDU市场概况 ...

《报告》提出,虽然当前液冷应用场景仍相对集中,但无论是生态链供应商还是用户端侧都充分意识到液冷技术在节能减排、提高数据中心能耗利用率等方面具有积极作用,同时得益于服务器市场的整体加速扩大,液冷服务器的应用也更加广泛。 网宿科技旗下的液冷解决方案提供商绿色云图运营总监徐明微表示,保障AI芯片的性能与运行稳定尤为关键,这要求液冷系统更加安全可...

2025年对于数据中心行业而言,注定是一个特殊的年份。 一方面,包括《关于加快构建全国一体化大数据中心协同创新体系的指导意见》、《信息通信行业绿色低碳发展行动计划(2022-2025年)》等在内的多份政策性文件都将2025年作为重要时间节点。 另一方面,移动、联通、电信三大运营商在2023年联合发布的《电信运营商...